앞으로의 스마트 기기를 위한 UX 이해 - 시각과 음성

관련 글

방어의 LG전자 V20, 그리고 공격의 애플 아이폰(링크)

과거부터 우리는 무엇인가를 지시할 때 시각적인 것과 음성적인 것 두 가지로 지시해왔다. 이것은 정보를 얻는 방법이 시각적인 것과 청각적인 것 두 가지가 압도적이기 때문이다. 촉각은 구현하기 힘들며 미각과 후각은 시각과 청각을 통한 재현이 가능하다. 예를 들면 100g의 물에 소금 10g이라고 하여 공유한다면 그 수준의 짠맛을 재현할 수 있다. 이렇게 정보 획득의 역사와 함께해온 시각과 청각은 시대가 변해도 달라지지 않는다. 그런 관점에서 앞으로의 디바이스를 통한 제어는 다음과 같이 볼 수 있지 않을까 한다.

1. 시각 중심

|

화면에서 보이는 정보를 중심으로 제어하게 된다. 시각적인 측면이 강하기에 피드백도 정밀하고 즉각적이다. 넓은 화면은 많은 정보다. 하지만 크기가 커지면서 발생하는 휴대성의 문제는 태생적이다. 주로 손에 들고 다니거나 가방에 넣고 다닌다.

2. 낮은 시각과 낮은 음성

|

손목 위라는 공간은 태생적으로 좁은 화면을 가지고 시작하기에 많은 정보를 표시할 수도 자세한 정보를 표시할 수도 없다. 그러므로 전달하는 정보는 단편적이거나 단순한 정보가 된다. 이는 장단점을 동시에 가지는 데 장점으로 본다면 간단한 것을 처리하는데 큰 것(스마트폰, 태블릿 등)을 쓸 필요가 없다는 점이다. 이메일을 보내기 위해 PC대신 스마트폰을 쓰듯이 말이다. 그러나 간단하지 않은 것에는 여전히 태생적인 단점이 된다.

음성적인 측면도 마찬가지다. 손목이라는 공간이 애초에 음성을 위한 UX 공간은 아니다. 그러므로 손목을 입에 대는 과정이 필요한데 이는 자연스럽지 않다.

시각 중심과 음성 중심의 가운데에서 이도 저도 아닌 존재 같지만 모션 트래킹과 홍채인식 보안 같은 수단과 결합한다면 대체 불가능한 존재가 될 것이다.

3. 음성 중심

|

기술 발전으로 음성인식의 수준이 올라가며 성장하고 있는 부분이다. 단순하고 크게 중요하지 않으며 반사적으로 하는 행동들이 이 음성을 통해서 제어하기 적합하다. 집에 들어와서 불을 켜는 것 같은 행동은 습관적이고 반사적으로 하는데 사용자가 움직여서 스위치를 켜거나 스마트폰을 꺼내 관련 앱을 실행하고 메뉴를 선택해서 ON을 하는 것보다 "불 켜." 이것이 훨씬 간단하기 때문이다. 최근 사용자의 목소리만 더 집중적으로 걸러내는 기술이 발전함에 따라 환경의 제약 또한 점차 완화될 것이다. 다만, 음성 정보가 시각 정보만큼 정밀하지도 다채롭지도 않다는 것은 한계다.

|

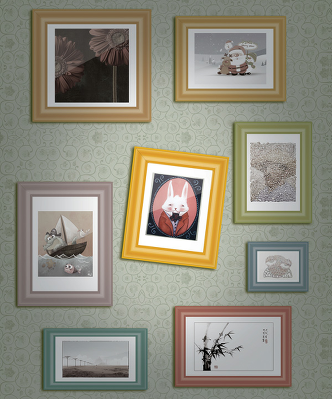

이 기울어진 액자를 바로 잡는다고 생각해보자. 시각적인 제어라면 기울어짐을 숫자로 정리하여 그 숫자만큼의 값을 입력하고 점점 수평을 맞춰가는 모습을 보면서 빠른 피드백이 가능하다. 하지만 음성은 그것이 안 된다. 약간, 더 이런 식의 대략적인 지시가 주를 이룰 것이다. 그렇다면 시각과 음성 서비스 설계 시 각각 어떤 UX를 가정해야 할까? 시각 중심의 UX라면 음성 제어가 없어도 완벽히 된다면 적절한 완성도를 가진 것이다. 음성 중심의 UX라면 반대로 시각이 차단된 상황에서도 완벽히 제어할 수 있다면 적절한 완성도를 가진 것이다.

그렇다면 이제 수평적인 이동은 해서는 안 된다. 스마트폰에서 시각 중심으로 메일 보내던 UX를 단순히 음성으로 명령어를 바꾼 뒤 이제 말로 메일 보내세요라고 한다고 그것이 음성 환경에 적합한 UX를 보장하지는 않기 때문이다. 애플이 시리를 에어팟과 함께 무선 제어의 수단으로 확장하려는 이때 좀 더 사용 환경에 대한 고민이 필요하다.

)